はじめに

もう年末ですね。

今年一年クレアヴォイアンスではAIを使ったサービス「kikitAI」の開始をしました。

「kikitAI」

そこで今回は自分のPCでも動くローカルAIに関しての記事です。

🤖ローカルAIとクラウドAI👾

CHATGPTやGoogle Geminiなど、 今では多くのAIアシスタントが出ていますが

これらは全てクラウドAIと呼ばれるクラウド上でサービスを利用しているものです。

ローカルAIは自分のPCや、社内にあるサーバに公開されているAIモデルを積んで

自分だけのAIを作成して利用すると言う物。

では、実際にやってみよう🧐

実はこのローカルAIの導入から利用までは意外と簡単です。

🤖必要な物🤖

- PC (今回はWindows11)

NVIDIA GPUがあればベスト(VRAM 6GB以上あると快適)

GPUなくてもCPUで動く(遅いだけ)

- ターミナル(今回はパワーシェルを利用)

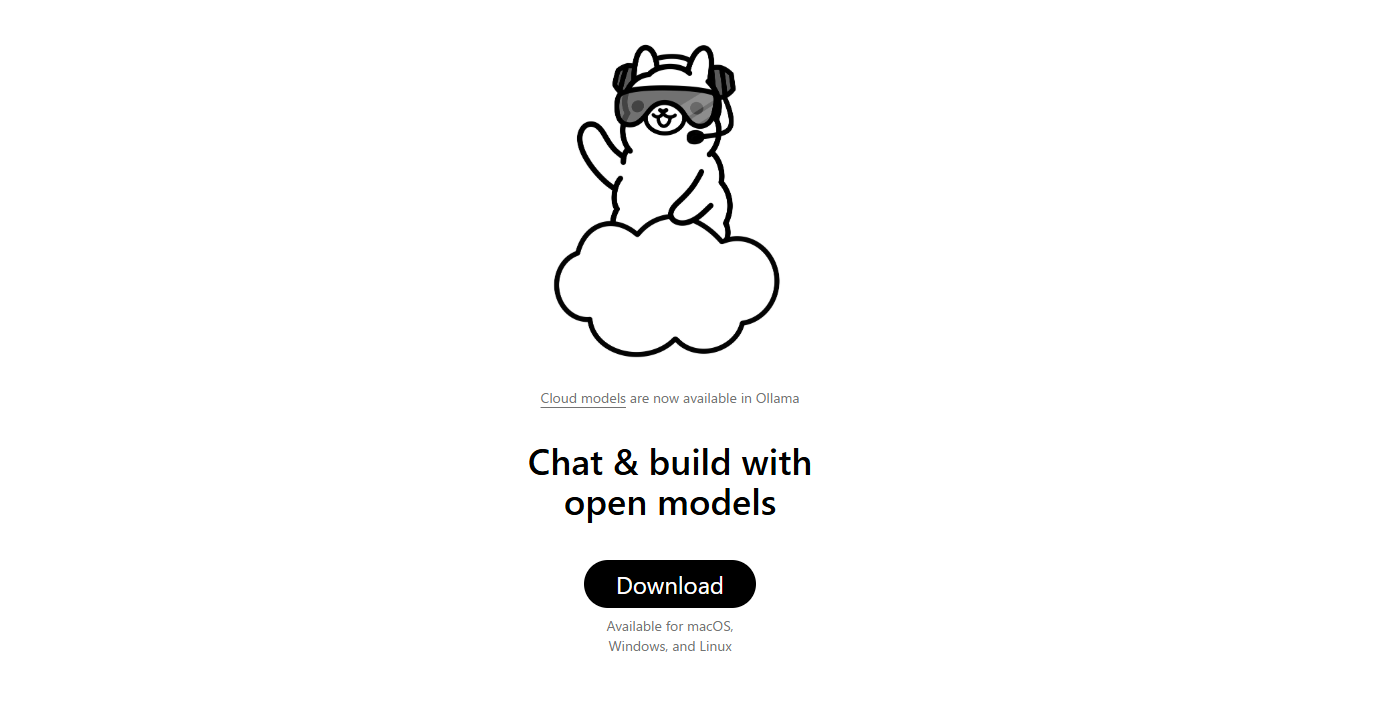

ローカルAIの王道「Ollama」

1️⃣Ollama をインストールする

① 公式インストーラを落とす

ブラウザで ↓

👉 Ollama 公式

→ Windows をクリック

→ OllamaSetup.exe をダウンロード

→ OllamaSetup.exe をダウンロード

② インストール実行

OllamaSetup.exe を ダブルクリック

途中は全部 Next / Install

完了したらOK

途中は全部 Next / Install

完了したらOK

📌 この時点で 裏で ollama サービスが常駐 する

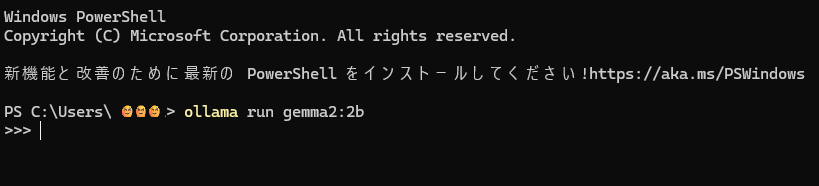

2️⃣ ターミナル(パワーシェル)を開く

スタート → パワーシェルで検索

3️⃣ Ollama が動いてるか確認

ollama --version

→ollama version 0.1.xx

こんな感じのがでればOK

4️⃣ Gemma2 2B モデルをダウンロード

使うモデルはとりあえず軽量のモデルにします。

ollama pull gemma2:2bモデルのボリュームが大きい程、学習しているデータ量が多く

推論の精度や最新情報の学習度合いが違います。

5️⃣ 実際に対話してみる(ここがゴール)

起動

ollama run gemma2:2b

こんな感じになり、何か喋ってあげましょう

返事が来たら成功

ローカルAI VS クラウドAI

| 項目 | ローカルAI | クラウドAI |

|---|---|---|

| 初期コスト | 高い(GPU/サーバー購入) | 低い(従量課金) |

| ランニングコスト | 低い(電気代のみ) | 高い(継続課金) |

| 推論速度 | スペック依存(遅め) | 高速 |

| 情報漏洩リスク | 低い | 中〜高 |

| 最新情報 | 学習されていない | 網羅されている |

| サーバー監視 | 必要 | 不要 |

| 学習コスト | 高い | 低い |

| 障害対応 | 自己対応 | ベンダー依存 |

年末の暇つぶしにAIと語り合ってみてください。

良いお年を🤡